Wort-Netzwerke in Texten

| David Valero Ribes | Larissa Kleppel | ||

|---|---|---|---|

| RWTH Aachen University | RWTH Aachen University | ||

| david.valero.ribes@rwth-aachen.de | larissa.kleppel@rwth-aachen.de |

Abstract

Twitter ist eine weltweit beliebte, von allen Altersgruppen und sozialen Schichten genutzte Online-Social-Media-Plattform, welche vornehmlich zur Verbreitung kurzer Textnachrichten und zur Kommunikation zwischen Mitgliedern genutzt wird. Nutzer mit beispielsweise ähnlichen Interessen oder Ansichten bilden dabei oft eine eigene Gemeinschaft. Inwiefern Sprache Hinweise auf den sozialen Hintergrund einer Community geben kann, soll in diesem Kapitel analysiert werden.

Dazu wird eine Methode zur Analyse des Wortgebrauchs der Nutzer einer Gemeinschaft vorgestellt und angewandt, sowie eine Möglichkeit aufgezeigt, auf deren Basis Unterschiede zwischen verschiedenen Communities zu bestimmen.

Dabei wird insbesondere deutlich, dass solche Gemeinschaften anhand von Wortstrukturen und -verwendung charakterisiert werden können. Umgekehrt ist es in einem gewissen Maße möglich, Nutzer durch diese Analyse einer Gemeinschaft zuzuordnen.

Keywords

Twitter; Sprache; Communities

Inhaltsverzeichnis

- Einleitung und Hintergrund

- Verwandte Arbeiten- Methodik

- Charakterisierung von Gemeinschaften anhand des Wortgebrauchs

- Erkennung von Zugehörigkeit zu einer Gemeinschaft- Anwendung des Algorithmus

- Datenset

- Finden der Communities

- Z-Score Ranking

- Vergleichen der Communities

- Analyse und Interpretation der Ergebnisse- Zusammenfassung und Ausblick

- Referenzen

Einleitung und Hintergrund

Die Online-Social-Media-Plattform Twitter wurde 2006 gegründet und wird als Kurznachrichtendienst genutzt (Arceneaux & Schmitz Weiss, 2010). Benutzer können sogenannte “Tweets” abschicken, welche auf 280 Zeichen begrenzt (Gligorić et al., 2018) sind und untereinander kommunizieren und diskutieren. Twitter ist heutzutage eine der wichtigsten Plattformen für den informellen Diskurs über aktuelle und allgemeine Themen im Internet. Die Nutzer stammen dabei aus allen Altersgruppen, wobei allerdings junge Erwachsene die größte Usergruppe darstellen (Aaron & Joanna, 2012). Im Laufe der Zeit sind bei Twitter viele Communities entstanden, die Themenlandschaft ist sehr weitreichend und vielseitig. Innerhalb dieser Gemeinschaften existieren oft auch “Untercommunities”, welche untereinander noch stärker vernetzt sind.

Im Gegensatz zu anderen Plattformen, wie beispielsweise Instagram, bei welcher der Austausch hauptsächlich auf Fotos und Bildern basiert, liegt bei Twitter der Schwerpunkt auf schriftlicher Kommunikation. Aus diesem Grund scheint der Ansatz, Communities anhand ihres Wortgebrauchs zu charakterisieren, durchaus sinnvoll.

In der realen Welt ist der Gebrauch von Sprache innerhalb von Gemeinschaften bereits weitreichend erforscht. Kulturelle und soziale Gruppen können in der Regel anhand der untereinander verwendeten Sprache (und in diesem Zusammenhang auch anhand des Wortgebrauchs) relativ zutreffend erkannt und charakterisiert werden. Inwiefern diese Charakterisierung auch online, in unserem Fall genauer gesagt auf Twitter, möglich ist, soll im diesem Kapitel betrachtet werden.

Dazu stellen wir einen Algorithmus vor, der den Wortgebrauch von Twitter-Gemeinschaften analysiert und durch welchen wir feststellen können, dass die Sprache innerhalb einer solchen Gemeinschaft sehr ähnlich ist. Außerdem ist es so möglich, einzelne Benutzer einer potenziellen Gemeinschaft zuzuordnen.

Verwandte Arbeiten

Dieses Kapitel und insbesondere die hier vorgestellte und verwendete Methodik basiert auf dem Paper “Word usage mirrors community structure in the online social network Twitter” von Bryden, Funk und Jansen (Bryden et al., 2013).

Methodik

Charakterisierung von Gemeinschaften anhand des Wortgebrauchs

Da wir Communities anhand des Wortgebrauchs charakterisieren möchten, wird zunächst eine durch einen Algorithmus gefundene Community \(c\) und ein beliebiges Wort ausgewählt und der Anteil \(\mu_c\) der Mitglieder von \(c\) bestimmt, welche das gegebene Wort benutzt haben. Zum Vergleich wird außerdem der Wert \(\mu_g\) bestimmt; dies ist der Anteil aller Nutzer des Datensets, welche das Wort je benutzten. Um diese beiden Werte adäquat zu vergleichen, wird der standardisierte Z-Score verwendet:

\[Z = \frac{\mu_c - \mu_g}{\sigma_g / \sqrt{N_c}}\]Hierbei ist \(N_c\) die Anzahl der Mitglieder der Gemeinschaft \(c\) und \(\sigma_g\) ist die Standardabweichung der Benutzung des Wortes durch alle Benutzer, definiert durch:

\[\sigma_g^2 = \mu_g (1-\mu_g)\]Anhand dieses Z-Scores kann die Wahrscheinlichkeit bestimmt werden, dass der Unterschied zwischen \(\mu_c\) und \(\mu_g\), also der Unterschied der Wortbenutzungshäufigkeit in der Gemeinschaft und jener im gesamten Datenset, zufällig war. Dieses Verfahren ist für jedes benutzte Wort des Datensatzes anwendbar. Hiermit kann eine Art Ranking von charakteristischen Wörtern einer Community erstellt werden (je höher der Z-Score eines Wortes, desto charakteristischer ist das Wort für die Community).

Neben der Möglichkeit eine Gemeinschaft auf diese Art und Weise zu charakterisieren, ist es außerdem möglich, Gemeinschaften anhand ihres Wortgebrauchs miteinander zu vergleichen. Betrachtet werden zwei Communities \(j\) und \(k\), sowie das Wort \(i\). Sei \(f_j(i)\) die relative Wortbenutzungshäufigkeit innerhalb der Gemeinschaft \(j\), also \(f_j(i)=\frac{t_j(i)}{t_j}\), wobei \(t_j(i)\) die Anzahl der Benutzungen des Wortes \(i\) und \(t_j\) die Gesamtzahl der benutzten Wörter, beide Werte jeweils innerhalb der Gemeinschaft \(j\) gemessen, ist. Mithilfe dieser relativen Häufigkeit kann nun der euklidische Abstand und somit der Unterschied zwischen den Gemeinschaften \(j\) und \(k\) berechnet werden:

\[d(j,k) = \sqrt{ \sum \limits_i [f_j(i) - f_k(i)]^2}\]Wie zuvor wird auch hier die Wahrscheinlichkeit bestimmt, dass der Unterschied, also in diesem Fall die euklidische Distanz, zufällig ist. Hierzu wird zunächst für das Paar von Gemeinschaften \(j\) und \(k\) die Vereinigung ihrer Mitglieder gebildet und aus dieser Vereinigung ein weiteres Paar von Communities \(j'\) und \(k'\) entnommen, welche jeweils gleich groß in Bezug auf ihre Mitgliederzahl sind wie \(j\) und \(k\). Nun lässt sich der euklidische Abstand beider Communitypaare \(j\) und \(k\) bzw. \(j'\) und \(k'\) vergleichen, es wird also überprüft ob \(d(j',k') > d(j,k)\) gilt. Die Häufigkeit des Auftretens dieses Falles erlaubt es, Rückschlüsse auf die Wahrscheinlichkeit zu ziehen, dass der Unterschied in der Wortbenutzung zwischen den Communities \(j\) und \(k\) zufällig war. (Bryden et al., 2013)

Erkennung von Zugehörigkeit zu einer Gemeinschaft

Neben der Charakterisierung einer Gemeinschaft und der Unterscheidung von Gemeinschaften anhand des Wortgebrauchs ist es weiterhin möglich, für einen einzelnen Nutzer vorherzusagen, welcher Gemeinschaft er am wahrscheinlichsten angehört. Hierzu wird der Wortgebrauch des Nutzers mit dem Wortgebrauch einer Community verglichen, um so die am besten passende Community für ihn zu finden. Die Nutzer des Datensets werden in zwei Gruppen unterteilt. Eine Gruppe besteht aus zufällig ausgewählten Testbenutzern und die andere aus den übrigen Nutzern. Aus der Gruppe der Testnutzer werden zufällig von dieser Gruppe benutzte Wörter gewählt.

Die relative Häufigkeit der Benutzung dieser Wörter wird nun für einen Testnutzer, für Communities der Gruppe der übrigen Nutzer und für alle Nutzer bestimmt. Die Differenz zwischen dem Wert des Testnutzer und jenem aller Nutzer, sowie zwischen den Werten der Communities und allen Nutzer, wird berechnet. Der Testnutzer wird nun der Community zugeordnet, deren Differenzwert am geringsten von seinem Wert entfernt ist. (Bryden et al., 2013)

Anwendung des Algorithmus

Datenset

Um diesen Algorithmus in der Praxis anzuwenden, haben wir ein umfangreiches Datenset (Kratzke, 2021) mit etwa 65 Millionen deutschen Tweets, bestehend aus monatlichen Stichproben von durch Twitter als deutschsprachig gekennzeichneten Tweets (die monatlichen Stichproben entsprechen etwa 10% des monatlichen Gesamtvolumens, wenn man die Anzahl der deutschsprachigen Tweets in April 2013 (Scheffler, 2014) als Grundlage nimmt), entstanden zwischen April 2019 und Dezember 2020, benutzt.

Unser Dank geht an dieser Stelle an Prof. Dr. Nane Kratzke, Lübeck University of Applied Sciences, welcher dieses Datenset zusammengestellt und es uns auf Anfrage zur Verfügung gestellt hat.

Die darin enthaltenen Tweet-IDs haben wir extrahiert und, um besser damit arbeiten zu können, neu hydriert (Tekumalla & Banda, 2020). Etwa 55 Millionen der Tweets unseres Datensets waren noch erhältlich, die übrigen 10 Millionen wurden entweder vom Nutzer selbst oder von Twitter gelöscht.

Finden der Communities

Aus unserem Datenset konnten wir daraufhin einen gerichteten Graphen kreieren. Jeder Nutzer stellt dabei einen Knoten dar und die Kanten dienen als Verbindung zwischen verschiedenen Nutzern. Diese Verbindungen basieren auf sogenannten Mentions, also die Erwähnung eines anderen Nutzers in einem Tweet durch das @-Symbol, sowie auf Antworten von Nutzern auf Tweets anderer Nutzer.

Insgesamt ist so ein Graph von etwa 4 Millionen Knoten und 20 Millionen Kanten entstanden. Die Modularität dieses Netzwerks beträgt \(Q = 0,58\) und ist somit im Vergleich zur erwarteten Modularität für zufällige Netzwerke (\(Q_{random} = 0,15\)) höher als erwartet.

Diesen gerichteten Graphen haben wir in einen ungerichteten Graphen verwandelt, indem wir nur Kanten behalten haben, welche in beide Richtungen gehen. Unser Endgraph hat somit 350.000 Knoten und etwa 1.500.000 Kanten, mit einer Modularität von \(Q = 0,69\).

Mithilfe der Python-Library von igraph (Csardi & Nepusz, 2006) konnten wir in diesem Graphen Communities mit dem Leiden-Algorithmus (Traag et al., 2020) bestimmen. Insgesamt haben wir 31 Communities gefunden, welche mehr als 250 Nutzer haben. In diesen Gemeinschaften befanden sich insgesamt etwa 300.000 der 350.000 Nutzer. Die größte Community hat etwa 48.250 Nutzer, die Kleinste 280. Der Median der Mitgliederanzahl liegt bei rund 4.650 und der Durchschnitt beträgt 9.600.

| Farbe: | ||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| User: | 48200 | 33300 | 31200 | 24300 | 18500 | 18300 | 16700 | 15300 | 12900 | 11300 | 10200 | 9000 | 7100 | 5900 | 5800 | 5400 |

| ID: | 0 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 | 11 | 12 | 13 | 14 | 15 |

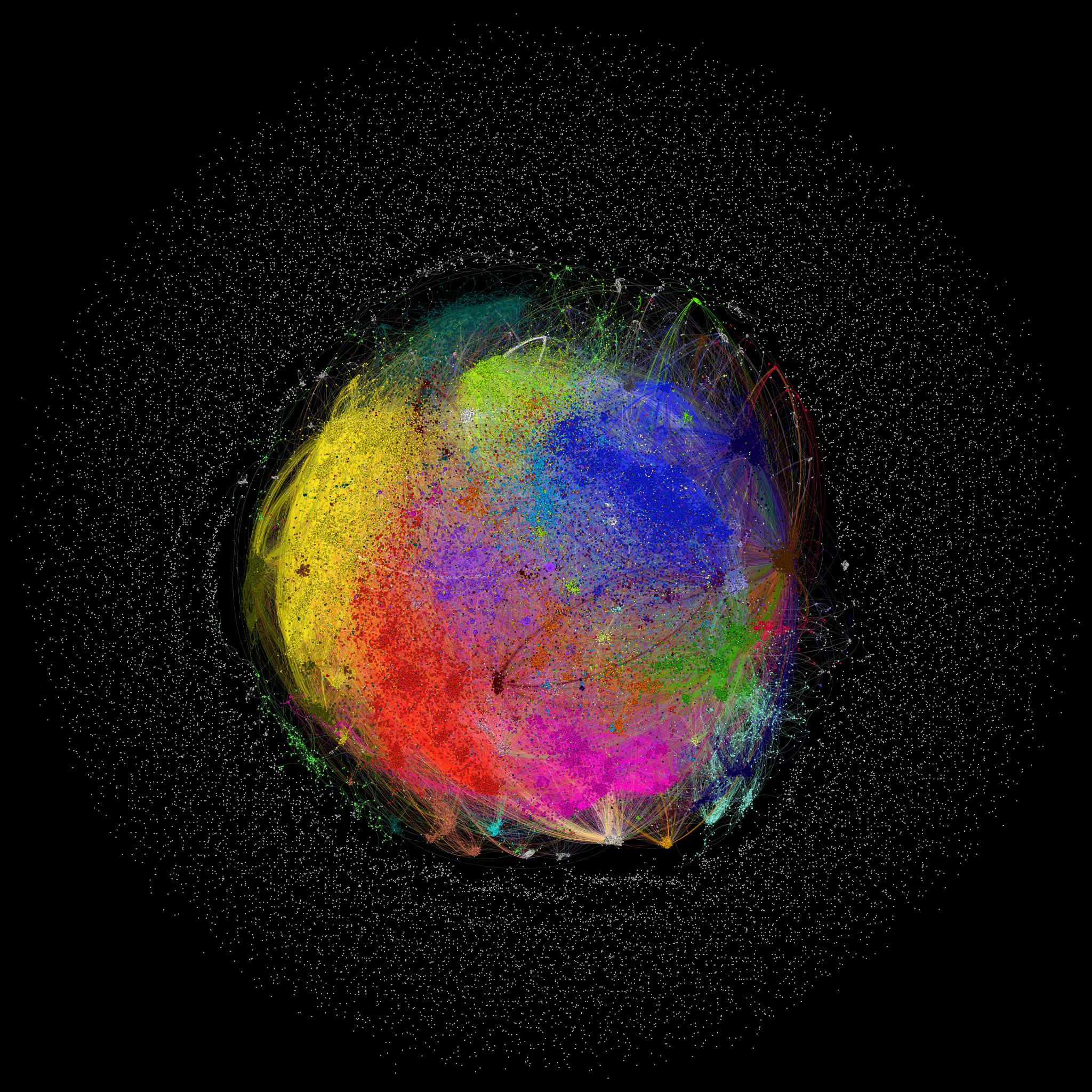

Der vollständige Graph zu unserem Datenset mit 350.000 Twitternutzern als Knoten und die 1.500.000 Kanten zwischen ihnen. Die 31 größten Communities sind farblich markiert. Communities mit mehr als 5000 User sind in der Legende aufgeschlüsselt. In Gephi (Bastian et al., 2009) mithilfe von OpenOrd (Martin et al., 2011) kreiert. Für höhere Auflösung das Bild anklicken.

Z-Score Ranking

Zur Wortanalyse der gefunden Communities mussten wir zunächst die globalen Worthäufigkeiten, sowie die relative Wortnutzung in jeder Community bestimmen. Insgesamt enthielten die Tweets über 850.000 verschiedene Wörter.

Ein Wort wurde dabei anhand der Leerzeichen definiert. Dabei wurden http-Links, sowie Wörter, die nur aus Zahlen bestehen und Sonderzeichen entfernt und letztere durch eine Worttrennung ersetzt. In Tweets vorhandene Emojis, in UTF-8-Codierung, wurden jedoch als Wort gewertet. Groß- und Kleinschreibung ist nicht berücksichtigt, allerdings konnten etwaige Rechtschreibfehler und Abkürzungen nicht aufgeschlüsselt werden.

Der Z-Score der Communities, sowie dessen Ranking, haben wir mit folgendem selbstgeschriebenen Java-Programm bestimmt:

private static Double standardDeviation(Double anteilVonUser) {

Double result = anteilVonUser * (1-anteilVonUser);

return Math.sqrt(result);

}

private static Double zScore(Double relativeGlobalWordUsage,

Double relativeCommunityWordUsage, Double standardDeviation,

Long anzahlVonCommunityUser) {

Double result = relativeCommunityWordUsage - relativeGlobalWordUsage;

return result/(standardDeviation/Math.sqrt(anzahlVonCommunityUser));

}

Vergleichen der Communities

Die gefundenen Communities konnten wir, wie in der Methodik beschrieben, auf Basis ihrer relativen Wortbenutzungshäufigkeit mithilfe des folgenden Java-Codes vergleichen:

public static double calculateEuclidDistance(WordCount firstCommunity,

WordCount secondCommunity) {

// WordCount is an Object containing a long with the

// total number of words used by the community

// and a hashmap where the key is the word and

// the value is how often that word was used

HashMap<String, Long> firstCount = firstCommunity.wordCount;

HashMap<String, Long> secondCount = secondCommunity.wordCount;

double result = 0.0;

// we iterate over every word from the first community

for (Entry<String,Long> word : firstCount.entrySet()) {

Long secondWord = Long.valueOf(0);

// if the second community has the word we get its usage.

if (secondCount.get(word.getKey()) != null) {

secondWord = secondCount.get(word.getKey());

}

// calculate the relative usage using the total word count of each community

double secondrelativ = (double) secondWord/secondCommunity.totalWordCount;

double firstrelativ = (double) word.getValue()/firstCommunity.totalWordCount;

// sum results from all words

result += calculateInnerEuclid(firstrelativ, secondrelativ);

}

// return the square root of that sum

return Math.sqrt(result);

}

public static double calculateInnerEuclid(double first, double second) {

double result = first-second;

result = Math.pow(result, 2);

return result;

}

Analyse und Interpretation der Ergebnisse

Wir haben alle 31 Communities mit mehr als 250 Mitgliedern genauer betrachtet um zu beurteilen, ob eine Charakterisierung dieser nur anhand des Z-Scores möglich ist. Dazu nahmen wir die im Z-Score-Ranking höchsten 20 Wörter jeder Community und suchten daraus jeweils drei Wörter aus, die Rückschlüsse auf die Gemeinschaft geben können.

Bis auf wenige Ausnahmen ließ sich recht gut erkennen, welches “Thema” der Gemeinschaft zugrunde liegt. Bei wenigen Gemeinschaften war eine gemeinsame Linie nur schwer erkennbar, entweder gab es hier kein eindeutiges Thema oder es wurden verschiedene Themen vermischt, wobei denkbar ist, dass in diesem Fall die Gemeinschaft nochmal in eindeutigere Untercommunities aufteilbar ist. In den meisten Fällen ließen sich die Gemeinschaft allerdings gut auf Basis ihrer Wortbenutzungshäufigkeit unvoreingenommen und vorurteilsfrei charakterisieren.

Dies ist als Indiz dafür zu werten, dass einerseits der verwendete Algorithmus für die Entdeckung von Gemeinschaften offenbar richtig funktioniert und Communities gefunden hat, die weitestgehend gut voneinander zu unterscheiden sind und jede ein besonderes “Thema” hat, welches die Mitglieder einer Gemeinschaft verbindet und worüber in der Gemeinschaft kommuniziert und diskutiert wird. Andererseits lässt sich so auch erkennen, dass Mitglieder einer Gemeinschaft durch ähnliche Wortbenutzung miteinander verbunden sind und eine Community demnach anhand ihrer verwendeten Sprache charakterisiert werden kann.

Im nächsten Schritt haben wir die gefundenen Gemeinschaften miteinander durch Berechnung der euklidischen Distanz verglichen.

Dabei ist auffällig, dass Communities die, unter anderem, in anderen Sprachen schreiben (zum Beispiel Spanisch oder Luxemburgisch) zu allen anderen Gemeinschaften einen vergleichsweise hohen Abstand haben, was aufgrund der Verwendung nicht-deutscher Wörter allerdings zu erwarten war.

Betrachtet man jedoch die geringsten Abstände zwischen Communities, so lässt sich bei einigen Gemeinschaften gut nachvollziehen, warum diese nicht sehr weit voneinander entfernt sind (beispielsweise Community 0, welche offenbar viel über Politik allgemein redet und Community 10, welche auch über Politik, aber auffällig mehr über die AfD kommuniziert). Bei anderen Communities ist dieser geringe Abstand nicht auf den ersten Blick ersichtlich, aber wahrscheinlich darauf zurückzuführen, dass zwar nicht unbedingt die im Z-Score-Ranking oberen 20 Wörter ähnlich sind, sondern Wörter, die sich in diesem Ranking eher im (oberen) Mittelfeld bewegen, möglicherweise Ähnlichkeiten aufweisen.

Die höchste Distanz zwischen zwei Gemeinschaften betrug 0,087, die niedrigste 0,0061. 25% der Distanzen lagen über dem Wert 0,042, die unteren 25% lagen unter 0,0167. Insgesamt konnten wir einen durchschnittlichen Abstand von 0,0282 bestimmen.

Gleicher Graph zur Visualisierung der Communities der Communities

Weiterhin haben wir nicht nur Communities direkt miteinander verglichen, sondern, wie in der Methodik beschrieben, die Wahrscheinlichkeit betrachtet, dass der berechnete euklidische Abstand zufällig ist. Dazu haben wir zufällig 13 Paare von je zwei Communities gebildet und 50-mal neue, zufällige Communitypaare aus ihren Mitgliedern gebildet um zu bestimmen, wie oft \(d(j',k') > d(j,k)\) gilt (siehe Charakterisierung von Gemeinschaften anhand des Wortgebrauchs).

Bei 10 von 13 Paaren wurde diese Ungleichung nie erfüllt, die eigentliche euklidische Distanz war hier meist um ein Vielfaches höher als die der neu zusammengesetzten Communitypaare. Bei zwei der 13 Paare gab es ein bzw. zwei Mal eine größere euklidische Distanz bei den neu zusammengesetzten Paaren und bei einem Paar kam es 18 Mal zu diesem Fall, was allerdings als ein einziger, wenn auch ungewöhnlicher, Ausreißer nach oben zu sehen ist. Insgesamt lag die Distanz in 96,8% der berechneten Fälle unter der ursprünglichen euklidischen Distanz zwischen den Gemeinschaften.

Dies lässt darauf schließen, dass die euklidische Distanz nicht zufällig ist, sondern dass diese Communities tatsächlich so weit voneinander entfernt sind und ihre Sprachmuster durchaus verschieden sind. Der Abstand zwischen Gemeinschaften basiert also nicht nur darauf, dass über verschiedene Themen geredet wird, sondern auch darauf, wie die Kommunikation gestaltet ist. Hierbei bleibt aber zu beachten, dass viele Nutzer durchaus auch ihre Sprache ändern, je nachdem mit wem sie kommunizieren (Tamburrini et al., 2015). Gehören sie zu einer Community, so ist die Wahrscheinlichkeit, dass sich ihre Sprache “anpasst”, recht hoch. Inwiefern dies das Sprachmuster und die Charakterisierung von Communities beeinflusst oder Communities davon beeinflusst werden, geht jedoch über den Inhalt dieses Kapitels hinaus.

BubbleChart der im Z-Score-Ranking jeweils höchsten 25 Wörter von vier ausgewählten Communities. Zum Betrachten von einzelnen Communities andere Communities in der Legende anklicken. Mit dem Cursor über eine Blase gehen, um den Z-Score eines Wortes zu sehen. Die Größen der Blasen sind proportional zum Z-Score der Wörter.

Zusammenfassung und Ausblick

Durch die Analyse des Wortgebrauchs innerhalb einer Community im Vergleich zum globalen Wortgebrauch des deutschen Teils der Online-Social-Media-Plattform Twitter ist es uns gelungen, Gemeinschaften, die durch einen Algorithmus zur Entdeckung von Communities gefunden wurden, zu charakterisieren und gemeinsame Interessen zu erkennen. Es ist daher durchaus möglich, anhand des Sprachmusters das “Thema” einer Gemeinschaft zu identifizieren und diese zu beschreiben.

Außerdem kann auf diese Weise ein Nutzer einer Community zugeordnet werden, nämlich derjenigen, deren Sprachmuster am besten zum Sprachmuster dieses Nutzers passt.

Allgemein sind die Ergebnisse dieser Analyse als Beweis dafür zu sehen, wie Sprache und Wortbenutzung die Struktur der Gesellschaft widerspiegeln und Individuen in diese Struktur einzuordnen sind, abhängig von ihrem Sprachmuster. Sprache ist online, wie in der realen Welt, ein Indikator für Charakter, Interessen und gesellschaftliche Stellung jedes Menschen.

Die gewonnenen Erkenntnisse haben das Potenzial, die Analyse gesellschaftlicher und kultureller Gruppen zu erweitern oder zu erleichtern. So ist beispielsweise nicht nur die Charakterisierung von Gemeinschaften denkbar, sondern auch Methoden zur Findung von Gemeinschaften durch Sprachanalyse. Auch andere, von Online-Social-Media-Plattformen genutzte Algorithmen, wie beispielsweise solche zur Empfehlung von Hashtags, können so verbessert werden (Alsini et al., 2020).

Weiterhin kann in den Bereichen Soziologie und Politik Sprach- und Wortanalyse von Communities verwendet werden, um aufstrebende Themen und deren Diskurs rund um Politik und Zeitgeschehen, sowie Meinungen und Positionen verschiedener Gemeinschaften und Gruppen zu analysieren und daraus Rückschlüsse zur Beantwortung und Lösung verschiedenster Fragen und Probleme zu ziehen (Cataldi et al., 2010).

Mögliche Einsatzgebiete und denkbare Anwendungen von Sprachanalyse von Online-Communities scheinen also vielfältig. Allerdings gibt es auch hier Grenzen, die die Anwendbarkeit mehr oder weniger einschränken können. Um Sprachanalyse zu betreiben muss zunächst genug Kommunikation stattfinden. Je weniger innerhalb einer Gemeinschaft kommuniziert wird, desto schwächer ist die Aussagekraft der Analyse des Wortgebrauchs. Außerdem ist nicht nur die Quantität der Kommunikation wichtig, sondern auch die Art. Die Grundlage an dieser Stelle ist eine gemeinsame Sprache. Auch wenn beispielsweise nur deutschsprachige Communities betrachtet werden, können Nutzer, die mehrsprachige Nachrichten schreiben (also solche, die zwischen verschiedenen Sprachen hin und her wechseln, wobei dies insbesondere dank der Stellung der englischen Sprache sogar innerhalb einer Nachricht nicht mehr unüblich ist) die Analyse stören. Ebenfalls störend sind Rechtschreibfehler, grammatikalische Konstrukte (beispielsweise die Konjugation von Verben oder die Deklination von Nomen und Adjektiven), verwendete Abkürzung, ungewöhnliche benutzte Sonderzeichen und Zahlen und andere Eigenheiten, die bei der Online-Benutzung von Schriftsprache entstehen.

Referenzen

- Arceneaux, N., & Schmitz Weiss, A. (2010). Seems stupid until you try it: press coverage of Twitter, 2006-9. New Media & Society, 12(8), 1262–1279. https://doi.org/10.1177/1461444809360773

- Gligorić, K., Anderson, A., & West, R. (2018). How Constraints Affect Content: The Case of Twitter’s Switch from 140 to 280 Characters. https://arxiv.org/pdf/1804.02318

- Aaron, S., & Joanna, B. (2012). Twitter Use 2012. Pew Research Center and Pew Internet & American Life Project.

- Bryden, J., Funk, S., & Jansen, V. A. A. (2013). Word usage mirrors community structure in the online social network Twitter. EPJ Data Science, 2(1). https://doi.org/10.1140/epjds15

- Kratzke, N. (2021). Monthly Samples of German Tweets. Zenodo. https://doi.org/10.5281/ZENODO.4412213

- Scheffler, T. (2014). A German Twitter Snapshot. Proceedings of the Ninth International Conference on Language Resources and Evaluation (LREC’14), 2284–2289. http://www.lrec-conf.org/proceedings/lrec2014/pdf/1146_Paper.pdf

- Tekumalla, R., & Banda, J. M. (2020). Social Media Mining Toolkit (SMMT). Genomics & Informatics, 18(2), e16. https://doi.org/10.5808/GI.2020.18.2.e16

- Csardi, G., & Nepusz, T. (2006). The igraph software package for complex network research. InterJournal, Complex Systems, 1695(5), 1–9.

- Traag, V., Zanini, F., Gibson, R., Ben-Kiki, O., & van Kuppevelt, D. (2020). vtraag/leidenalg 0.8.2. Zenodo. https://doi.org/10.5281/zenodo.4047113

- Bastian, M., Heymann, S., & Jacomy, M. (2009). Gephi: An Open Source Software for Exploring and Manipulating Networks. Unpublished. https://doi.org/10.13140/2.1.1341.1520

- Martin, S., Brown, W. M., Klavans, R., & Boyack, K. W. (2011). OpenOrd: an open-source toolbox for large graph layout. Visualization and Data Analysis 2011, 786806. https://doi.org/10.1117/12.871402

- Traag, V. A., Waltman, L., & van Eck, N. J. (2019). From Louvain to Leiden: guaranteeing well-connected communities. Scientific Reports, 9(1), 5233. https://doi.org/10.1038/s41598-019-41695-z

- Tamburrini, N., Cinnirella, M., Jansen, V. A. A., & Bryden, J. (2015). Twitter users change word usage according to conversation-partner social identity. Social Networks, 40, 84–89. https://doi.org/10.1016/j.socnet.2014.07.004

- Alsini, A., Datta, A., & Du Huynh, Q. (2020). On Utilizing Communities Detected From Social Networks in Hashtag Recommendation. IEEE Transactions on Computational Social Systems, 7(4), 971–982. https://doi.org/10.1109/TCSS.2020.2988983

- Cataldi, M., Di Caro, L., & Schifanella, C. (2010). Emerging topic detection on twitter based on temporal and social terms evaluation. Tenth International Workshop on Multimedia Data Mining: MDMKDD ’10. https://doi.org/10.1145/1814245.1814249